Affectiva está desarrollando una tecnología que permite hacer análisis de emociones sólo mediante la voz.

Imagina que acompañas a tu primo a traer los resultados de su examen privado previo graduarse. Ese día le notifican si se gradúa o si debe repetir el semestre.

Es un momento tenso y de mucha expectativa. Al salir, no te dice nada, pero ves en su rostro una expresión de frustración. En esta situación, no es necesario oír la voz de tu primo para entender su estado emocional.

Ahora imagina esta escena: Luego de 5 años de estar intentando un ascenso en su trabajo, tu hermana te llama por teléfono y con una voz acelerada te dice “¡Te tengo una noticia de mi trabajo! ¿Adivina que me dijo mi jefe?”

En este caso, no necesitas ver su rostro para saber que está emocionada. La forma en que te habla está pintando la escena en tu mente y puedes imaginar su expresión de felicidad.

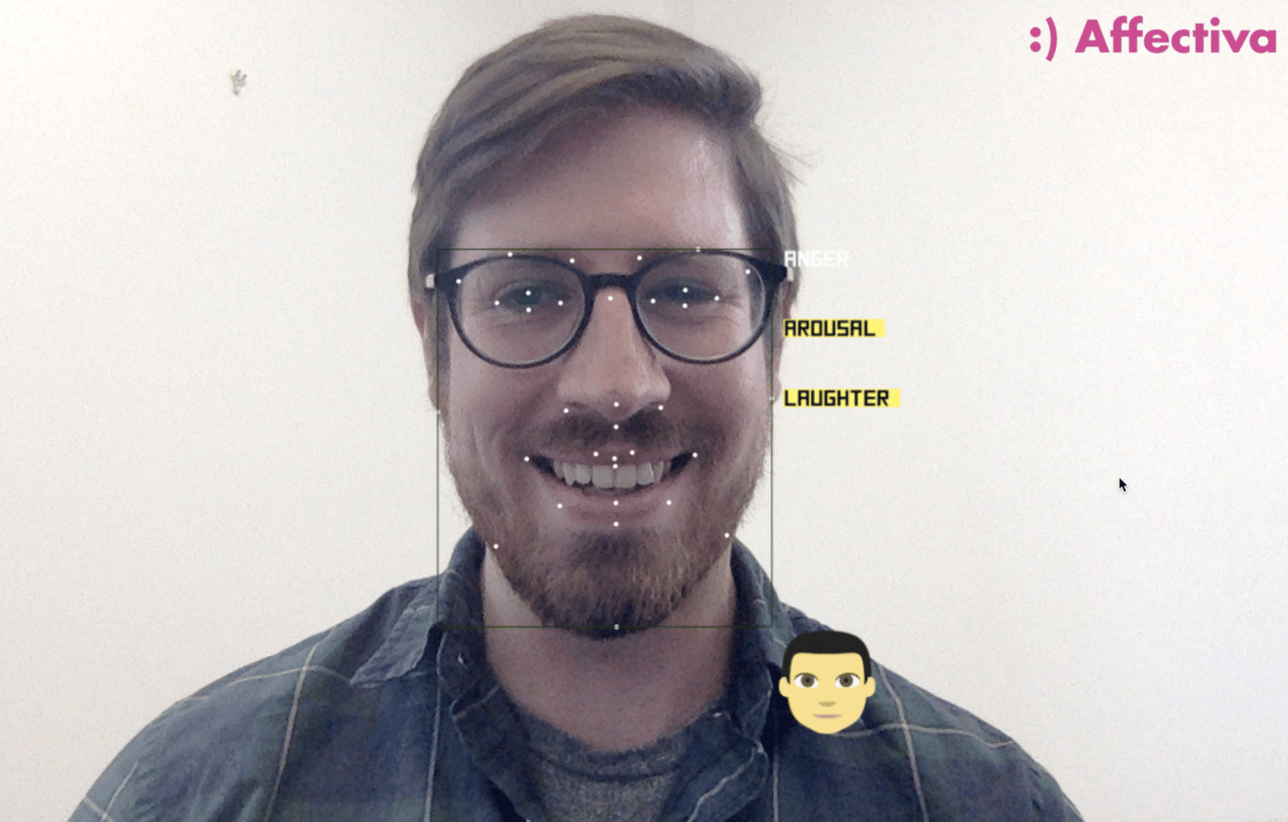

Ambos métodos para interpretar emociones son válidos y necesarios. La agencia Affectiva, pionera en computación afectiva, ya se ha dado a conocer por su tecnología enfocada a la interpretación de expresiones faciales.

Pero aún con todo ese conocimiento y capacidad de interpretación de rasgos faciales, no hay duda que la forma más confiable de analizar las emociones es cuando puedes ver y oír a una persona.

Por eso, Affectiva se metió de lleno a este nuevo ámbito del reconocimiento de las emociones a través de la voz.

La voz se está volviendo tendencia

Actualmente, si necesitamos buscar información, la mayoría de nosotros nos valemos de un teclado para ingresar nuestra búsqueda en los dispositivos móviles o computadoras de escritorio.

Pero si analizamos los últimos avances de la tecnología, es fácil ver que esto podría cambiar.

Esta nueva tecnología de Affectiva fue anunciada sólo meses después de que Adobe anunciara su nuevo programa para edición de voz: Adobe VoCo.

En los últimos meses están saliendo varias apps dedicadas al contenido en voz, como Anchor, que te permite crear mini podcasts más conversacionales, sin la necesidad de preproducción.

Anchor es descrita como las Instagram Stories en versión voz: es decir, pedacitos de una historia sin preproducción, que se comparten y luego desaparecen.

Por otro lado, el controversial Gary Vaynerchuk ha comentado recientemente en repetidas ocasiones que la voz como método de conexión con la tecnología estará tomando cada vez más relevancia.

Según comenta Gary en el video de abajo, la mayor preocupación de Google no es Bing, Yahoo o Facebook: es Amazon.

Esto se debe a que en la actualidad, 1 de cada 4 búsquedas se hacen por medio de voz. Y Amazon está liderando la implementación de asistentes para el hogar que funcionan por medio de voz, con su Amazon Alexa.

Todos estos eventos aparentemente aislados apuntan a que la voz se está perfilando como el método de ingreso de información que podría sustituir a los teclados.

Pero regresando al tema del análisis de las emociones por medio de la voz, aquí te presentamos un resumen de la entrevista que el equipo de Affectiva le hizo a Taniya Mishra, la científica que lidera el proyecto de análisis de la voz.

¿Por qué el análisis de la voz es importante para las soluciones que ofrece Affectiva?

En términos generales, mientras se vuelve más común la tecnología de los chatbots y asistentes con inteligencia artificial, la sociedad quiere que la interacción con esos asistentes artificiales sea lo más humana y natural posible.

En este sentido, Affectiva ya ha avanzado al agregarle un componente tecnológico a las reacciones humanas. Es decir, con su tecnología de análisis de emociones por medio de las expresiones faciales.

Sin embargo, una expresión facial sólo te cuenta parte de la historia. Los humanos expresamos emociones a través de muchos otros canales, no sólo a través de los gestos faciales.

De acuerdo a los estudios de comunicación no verbal, las palabras influencian sólo en un 7% la percepción de un estado afectivo.

El tono de la voz y el lenguaje corporal contribuyen otro 38%, y la comunicación personal aporta otro 50%.

Tomando en cuenta esto, cuando analizamos las expresiones faciales, sólo estamos analizando uno de los canales que nos dan información sobre el estado emocional de una persona.

Por eso, necesitamos un segundo canal de información. Por eso, Affectiva ha comenzado a analizar la voz.

Affectiva ya es conocida por su tecnología de reconocimiento facial, pero estamos empezando a implementar nueva tecnología que nos permite analizar el rostro y la voz al mismo tiempo.

¿A dónde quiere llegar Affectiva con el análisis de emociones a través de la voz?

Queremos medir las seis emociones básicas:

- Enojo

- Disgusto

- Miedo

- Felicidad

- Tristeza Y

- Sorpresa.

Imaginate la posibilidad de que alguien se enoje con su Amazon Alexa, o con Google Home, y estos aparatos sean capaces de detectar las emociones en el tono de voz.

Entonces serían capaces de contestar algo como “Disculpame por este inconveniente, ¿Cómo puedo ser más útil?”

En pocas palabaras, queremos ayudar a las empresas a que ofrezcan una mejor experiencia al usuario.

Queremos medir detalles del habla interesantes, como risas, suspiros, gruñidos o pausas llenas como «um» o «uh».

Cada uno de estos detalles señala las emociones y actitudes que el hablante desea transmitir. Por ejemplo, las pausas frecuentes indican que todavía estoy pensando y no estoy listo para dejar mi turno en la conversación.

Por medio del análisis de voz queremos estimar las características de las personas como su género, edad y acento.

Por ejemplo, un niño está usando la Alexa de Amazon para ordenar cinco muñecas; el sistema debería ser capaz de reconocer que se trata de un niño y decir algo así como: «Hablemos con tus padres».

Por lo tanto, conocer la edad aproximada y otra información demográfica puede ser muy útil para que los asistentes personales automatizados procesen y respondan adecuadamente a las solicitudes de los usuarios.

Todos estos escenarios son la razón perfecta de por qué tenemos que estimar las emociones multimodalmente.

Taniya Mishra termina con estas palabras:

En Affectiva nos tomamos en serio la estimación de las emociones y queremos construir sistemas que sean sólidos y capaces de utilizar cualquier canal de información disponible, donde se encuentre la cara o la voz, o ambos.

Como primer paso hacia la estimación de emoción multimodal, además de nuestras métricas basadas en la cara, Affectiva está haciendo que el conjunto inicial de métricas del habla (género, excitación, risa, ira) esté disponible a través de un programa beta.

Como puedes ver, los análisis de neuromarketing no necesariamente se delimitan a las reacciones del cerebro, sino puede enriquecerse con otras fuentes de información biométrica.

Te animamos a que sigas investigando la tendencia del crecimiento de la voz como método de conexión con la tecnología, porque de seguro ese es el camino que seguirá la tecnología.

Consultor de Marketing Digital y Branding. Apasionado por el Neuromarketing y la tecnología que está cambiando la forma en que nos comunicamos.